Was Entscheider und Aufsichtsräte wissen müssen

Einleitung

Methoden der Künstlichen Intelligenz (KI) und des Machine Learnings haben sich längst in marktgängigen Produkten und Dienstleistungen niedergeschlagen. Die Nutzung von Methoden der KI unterscheidet sich von klassischen Algorithmen hauptsächlich dadurch, dass KI-Methoden keine fest einprogrammierten Regeln beinhalten, sondern Regeln aufgrund der Datenlage selbst durch die Maschine gefunden oder optimiert werden (dynamische Anpassung). Dies bedeutet, nicht mehr allein der menschliche Entwickler ist Herr der Regelwerke für Entscheidungen, sondern algorithmische Regeln entstehen und evolvieren auf Grundlage von – sich möglicherweise im Zeitverlauf ändernden – Datenstichproben eigenständig. Sofern nun dieser dynamische Ansatz breiten Eingang in Waren und Dienstleistungen findet, ist es durchaus folgerichtig zu fragen, wie mit daraus folgenden Risiken im Geschäftsverkehr umzugehen ist. Es war daher nur eine Frage der Zeit, dass der Gesetzgeber darauf reagiert und Regularien zur Governance von KI im professionellen Umfeld entwirft. Auf Ebene der Europäischen Union hat sich dies im April 2021 durch den Kommissionsvorschlag einer neuen EU-Verordnung manifestiert (Gesetz über Künstliche Intelligenz, Artificial Intelligence Act, Europäische Kommission, 21.04.2021). Auch wenn dieser Entwurf im Zuge des Gesetzgebungsverfahrens weiter angepasst wird, zeigt er sehr deutlich, in welche Richtung die zukünftige Regulierung, die mit empfindlichen Sanktionen belegt ist, gehen wird.

Dieser Beitrag möchte dieses vorläufige Regelwerk zusammenfassen, um Entscheidern und Aufsichtsräten zu verdeutlichen, vor welchen Fragestellungen sie zukünftig stehen, wenn Methoden der KI vermehrt Einzug in ihre Organisation halten werden.

Was ist der Europäische Artificial Intelligence Act?

Der EU Artificial Intelligence Act – ausgeschrieben: Verordnung des Europäischen Parlaments und des Rates zur Festlegung harmonisierter Vorschriften für Künstliche Intelligenz und zur Änderung bestimmter Rechtsakte der Union – wurde im April 2021 als Vorschlag veröffentlicht. Mit der Verordnung will man Forderungen nach legislativen Maßnahmen zur Gewährleistung eines reibungslos funktionierenden Binnenmarkts für Systeme der künstlichen Intelligenz (KI-Systeme), mit denen sowohl der Nutzen als auch die Risiken der KI auf Unionsebene angemessen geregelt werden, nachkommen. Durch die Regulierung soll also ein angemessenes Verhältnis zwischen Nutzen und Risiken der KI-Technologie erreicht werden.

Was ist KI im Sinne des EU Artificial Intelligence Act?

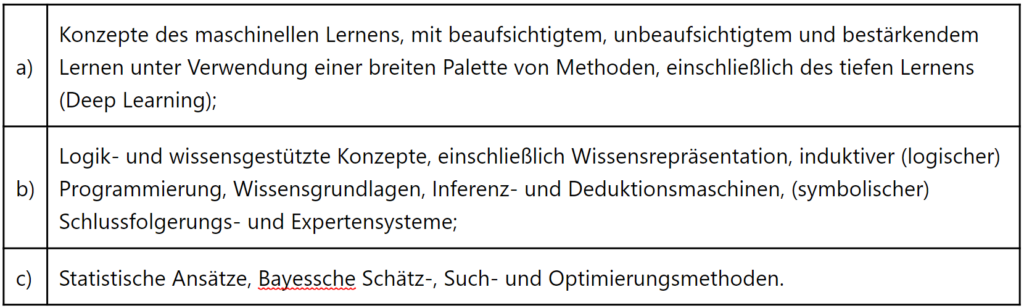

„KI oder nicht KI“: Organisationen müssen darüber entscheiden, ob sie wirklich ein KI-System einsetzen oder ob es sich um „normale“ Computerprogramme und Algorithmen handelt. Nur wenn ein KI-System vorliegt, ist der Artificial Intelligence Act überhaupt zu berücksichtigen. Was KI ausmachen soll, wird in Anhang I (vgl. Europäische Kommission, 21.04.2021) geregelt:

Bei diesen Tatbestandsmerkmalen wird die Praxis zeigen müssen, ob eine angemessene Abgrenzung von KI-Systemen zu anderen Systemen gut und pragmatisch möglich ist. Statistische Ansätze findet man sicher in vielen Anwendungen. Inwiefern dies sogleich dazu führen sollte von KI zu sprechen, wird sicherlich noch viele Diskussionen aufwerfen.

Was reguliert der Artificial Intelligence Act?

Für Entscheider und Aufsichtsräte stellt sich zunächst die Frage, ob die eigene Organisation überhaupt Anwendungsbezüge zum EU Artificial Intelligence Act hat, mithin die Frage welche KI-Systeme unter den Regelungsbereich fallen und ob solche Systeme in der eigenen Organisation verwendet werden.

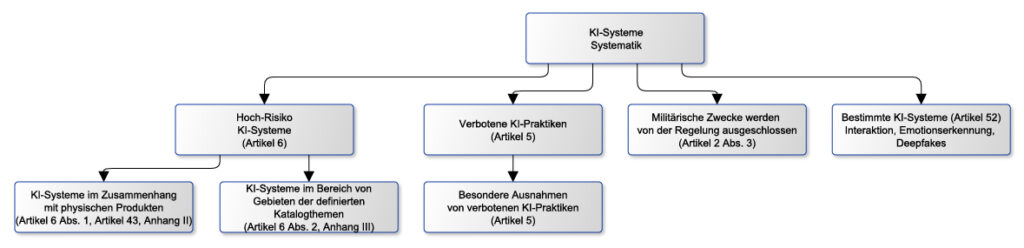

Unter die Regulierung fallen hauptsächlich sogenannte Hoch-Risiko KI-Systeme (Artikel 6). Wer kein Hoch-Risiko KI-System betreibt, verwendet oder anbietet, für den gelten die meisten Regelungen des EU AI Act nicht. Um dies jedoch zu beurteilen, ist es notwendig, die Tatbestandsmerkmale eines Hoch-Risiko KI-Systems zu kennen. Der Gesetzgeber arbeitet hier mit längeren Listen mit Anwendungsgebieten, die mit Hoch-Risiko KI-Systemen verbunden sein sollen. Abstrakte Merkmale von Hoch-Risiko KI-Systemen sind eher weniger zu finden, umso mehr handelt es sich um Kasuistik.

Abbildung 1 veranschaulicht die Systematik der Einteilung von relevanten KI-Systemen. Ausgenommen von den Regelungen des EU Artificial Intelligence Acts sind KI-Systeme, die rein militärische Zwecke verfolgen. Weiterhin werden bestimmte KI-Praktiken verboten, die insofern gar nicht Geschäftsgrundlage sein können. Verboten sind KI-Systeme, die das folgende bezwecken:

- Techniken der unterschwelligen Beeinflussung außerhalb des Bewusstseins einer Person, um das Verhalten einer Person in einer Weise wesentlich zu beeinflussen, die dieser Person oder einer anderen Person einen physischen oder psychischen Schaden zufügt oder zufügen kann.

- Ausnutzen von Schwäche oder Schutzbedürftigkeit einer bestimmten Gruppe von Personen aufgrund ihres Alters oder ihrer körperlichen oder geistigen Behinderung, um das Verhalten einer dieser Gruppe angehörenden Person in einer Weise wesentlich zu beeinflussen, die dieser Person oder einer anderen Person einen physischen oder psychischen Schaden zufügt oder zufügen kann.

- Verwendung von KI-Systemen durch Behörden oder in deren Auftrag zur Bewertung oder Klassifizierung der Vertrauenswürdigkeit natürlicher Personen über einen bestimmten Zeitraum auf der Grundlage ihres sozialen Verhaltens oder bekannter oder vorhergesagter persönlicher Eigenschaften oder Persönlichkeitsmerkmale (Social Scoring).

- Verwendung biometrischer Echtzeit-Fernidentifizierungssysteme in öffentlich zugänglichen Räumen zu Strafverfolgungszwecken (hier gibt es aber zugelassene Ausnahmen).

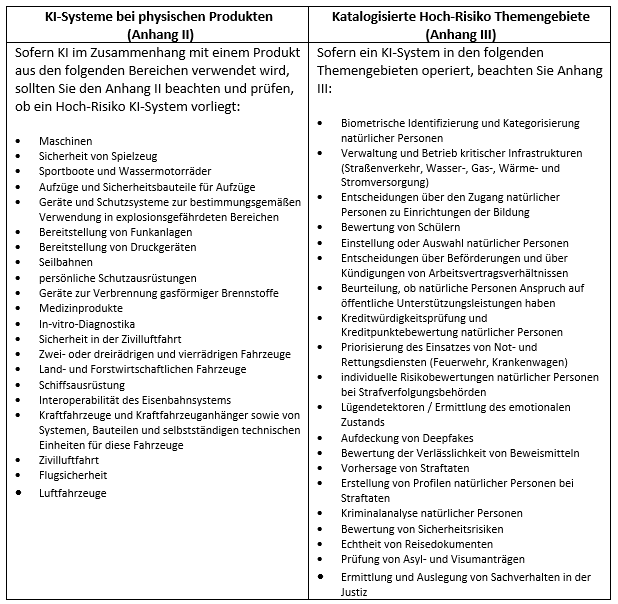

Letztlich interessant in der breiten Anwendung dürften die beiden Hoch-Risiko KI-Systeme Kategorien sein:

- KI-Systeme im Zusammenhang mit physischen Produkten (Anhang II des Acts)

- Katalogisierte Hoch-Risiko Themengebiete (Anhang III des Acts)

Die folgende Tabelle gibt dazu einen Überblick über konkrete Anhaltspunkte.

Hier geht es zu Teil 2

Hier geht es zu Teil 3

Co-Autorin

Marina Tcharnetsky ist Chief Business Development Officer sowie Ambassador des Artificial Intelligence Center Hamburg (ARIC) und seit über 20 Jahren in verschiedenen Funktionen und Bereichen der Wirtschaft tätig. Sie verfügt über langjährige Erfahrung in strategischer und operativer Führungsverantwortung in mittelständischen Unternehmen, börsennotierten Konzernen und technologie- und innovationsorientierten Startups. Flankiert wird dies durch ein langjähriges Engagement in verschiedenen ehrenamtlichen Tätigkeiten und Leitungsfunktionen in Non-Profit-Organisationen, u.a. als Vizepräsidentin des CeU (Club europäischer Unternehmerinnen).